如何查询网站的蜘蛛文件

2018-07-25 来源:SEO研究协会网

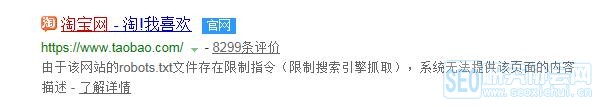

对于网站来说,如果网站不想被搜索引擎收录,就需要对网站设置蜘蛛文件,禁止被蜘蛛爬取,比如,现在的淘宝。

它已经脱离了搜索引擎,有了它自己的排名规则。不需要依赖搜索引擎。

但是对于大部分的企业网站来说,还是需要搜索引擎的,需要搜索引擎对页面进行收录,然后有好的排名,毕竟中国人用百度的比较多。所以很多企业在做百度的时候,还是希望自己建立的官方网站能有好的排名。

所以对于蜘蛛文件应该设置是能够被蜘蛛所抓取,所以有时候网页没有被收录,可以查询一下是否蜘蛛文件被限制了。这也是其中一个因素。站长朋友一定不能忽略。

查询蜘蛛文件,只需要在网址后面加上/robots.txt 。就能查询到蜘蛛文件是否被限制。希望可以帮助到你。

本文仅代表作者个人观点,不代表SEO研究协会网官方发声,对观点有疑义请先联系作者本人进行修改,若内容非法请联系平台管理员,邮箱cxb5918@163.com。更多相关资讯,请到SEO研究协会网www.west.cn学习互联网营销技术请到巨推学院www.jutuiedu.com。

它已经脱离了搜索引擎,有了它自己的排名规则。不需要依赖搜索引擎。

但是对于大部分的企业网站来说,还是需要搜索引擎的,需要搜索引擎对页面进行收录,然后有好的排名,毕竟中国人用百度的比较多。所以很多企业在做百度的时候,还是希望自己建立的官方网站能有好的排名。

所以对于蜘蛛文件应该设置是能够被蜘蛛所抓取,所以有时候网页没有被收录,可以查询一下是否蜘蛛文件被限制了。这也是其中一个因素。站长朋友一定不能忽略。

查询蜘蛛文件,只需要在网址后面加上/robots.txt 。就能查询到蜘蛛文件是否被限制。希望可以帮助到你。

本文仅代表作者个人观点,不代表SEO研究协会网官方发声,对观点有疑义请先联系作者本人进行修改,若内容非法请联系平台管理员,邮箱cxb5918@163.com。更多相关资讯,请到SEO研究协会网www.west.cn学习互联网营销技术请到巨推学院www.jutuiedu.com。

标签: seo 互联网 排名 企业网站 搜索 搜索引擎 搜索引擎收录 学习互联网

版权申明:本站文章部分自网络,如有侵权,请联系:west999com@outlook.com

特别注意:本站所有转载文章言论不代表本站观点!

本站所提供的图片等素材,版权归原作者所有,如需使用,请与原作者联系。

下一篇:为什么我的网站排名不高?

最新资讯

热门推荐